Historia del Big Data – Parte 1

Hoy decidimos analizar la comprensión de las tecnologías y enfoques para almacenar, procesar y analizar información, ahora conocida como Big Data, a través del prisma del tiempo. Este enfoque puede parecer un poco ingenuo para algunos, pero estamos seguros: no hay nada nuevo bajo el sol y se pueden encontrar fácilmente análogos de los problemas que enfrenta el hombre moderno en esta área en todas las etapas del desarrollo de la civilización, y nosotros. Como Hansel y Gretel, intentemos dejar un rastro de migajas de pan que nos saque del oscuro bosque de la historia hacia las luminosas praderas del conocimiento.

A lo largo de su historia, la humanidad, conscientemente o no, ha enfrentado y resuelto problemas de almacenamiento y procesamiento de información. Hace entre 10 y 20 mil años, los antepasados del hombre moderno usaban huesos para guardar los restos de las reservas recolectadas, presumiblemente para realizar actividades comerciales y tener un equilibrio predecible para las necesidades de alimentos. Esto es sólo una teoría, pero de ser cierto, este es el primer ejemplo de obtención y análisis de información en nuestra historia.

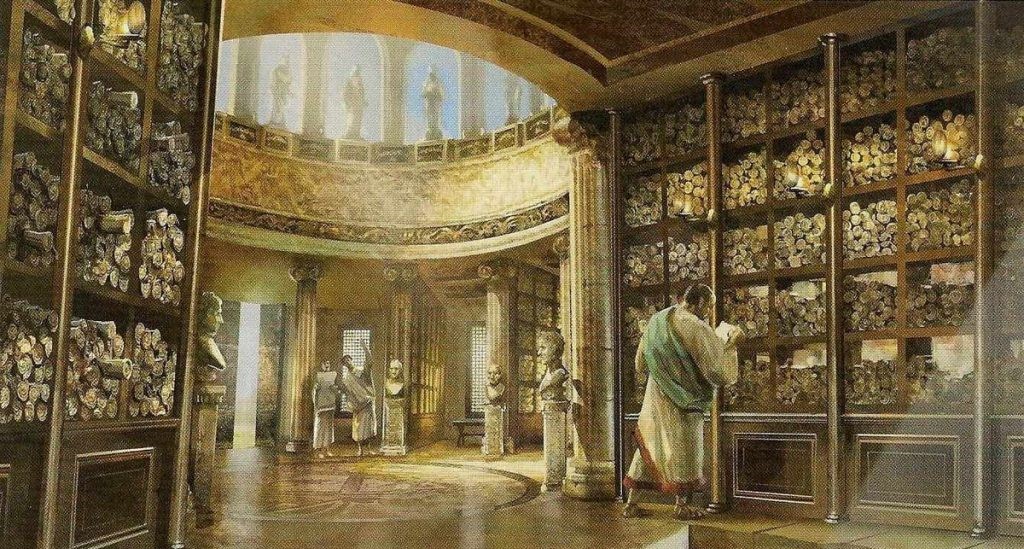

Las primeras bibliotecas de Babilonia en la década de 2000 a. C., y más tarde las bibliotecas de Alejandría, son ejemplos de cómo la gente en un momento u otro se enfrentó al problema de almacenar grandes cantidades de información y consolidarla para facilitar su uso. Los problemas entonces, sin embargo, se reducían principalmente a no perder toda la sabiduría acumulada durante la siguiente incursión enemiga, como ocurrió en Alejandría durante la invasión romana, cuando se perdió la mayor parte de la biblioteca.

No era necesario hablar de ningún análisis serio en nuestro contexto habitual de aquella época hasta mediados del siglo XVII, cuando John Grant, conocido entre otros por sus trabajos en el campo de la estadística demográfica, publicó una obra que describía una teoría. en el que el uso de analíticas de mortalidad permitió alertar sobre el inicio de la epidemia de peste bubónica.

En 1865, el profesor Richard Millar Devens acuñó por primera vez el término Business Intelligence, utilizándolo en su libro Cyclopedia of Commercial and Business Anecdotes, donde, entre otras cosas, contó a Henry Ferneze, quien alcanzó el éxito estructurando y analizando la actividad de información empresarial.

Con el aumento de la cantidad de datos que las personas comenzaron a utilizar en diversas áreas de sus actividades, surgieron cada vez más problemas con su procesamiento y análisis. Así, antes del censo de 1880, la Oficina del Censo estadounidense se enfrentó a una dificultad y anunció que con los enfoques modernos para trabajar con datos, solo podían contar durante 8 años, y en el siguiente censo de 1890, debido al aumento de la población y migración constante, será posible dar resultados precisos no antes de 10 años, cuando ya estarán completamente desactualizados. El resultado fue una situación en la que, en el momento de la siguiente recopilación de datos, los resultados del censo anterior aún no se habían analizado en su totalidad, lo que devaluó por completo esta información y puso en duda la existencia misma de la oficina.

Al rescate acudió un ingeniero llamado Herman Hollerith, quien en 1881 creó un dispositivo (tabulador) que, utilizando tarjetas perforadas, redujo 10 años de trabajo a 3 meses. Inspirado por el éxito, Hollerith creó la empresa TMC, especializada en la creación de máquinas tabuladoras. Posteriormente fue comprada por CTR, que pasó a llamarse IBM en 1924.

El mayor crecimiento de la información y los problemas que enfrentaron nuestros predecesores siempre se redujeron igualmente a cuestiones de almacenamiento y velocidad de procesamiento de estos datos.

Durante la Segunda Guerra Mundial, la necesidad de un análisis rápido de datos llevó a la creación de varias computadoras que podían descifrar los mensajes enemigos. Entonces, en 1943, los científicos británicos crearon la máquina Colossus, que aceleró el descifrado de mensajes de varias semanas a varias horas. El Coloso no tenía memoria personal como tal, por lo que los datos se suministraban a través de una rueda perforada. Es difícil imaginar ahora cuántas vidas salvó este ordenador antediluviano, según nuestros estándares, con una potencia de unos 6 megahercios y cómo habría cambiado el curso de la historia si no hubiera habido problemas con la velocidad de procesamiento de la información.

Pero la velocidad del análisis no es la única cuestión que desconcertó a nuestros predecesores a mediados del siglo XX. En 1944, el bibliotecario Fremont Rider publicó The Scholar and the Future of the Research Library , en el que analizaba que con el actual aumento de la producción, las bibliotecas deberían duplicar su capacidad cada 16 años. Esto conducirá al hecho de que, por ejemplo, la Biblioteca de Yale tendrá que constar de 6.000 millas (unos 10.000 km) de estanterías para 2040.

Además. A partir de la década de 1950, junto con la necesidad cada vez mayor de almacenar y procesar información, las tecnologías de almacenamiento comenzaron a crecer rápidamente y comenzaron a aparecer centros de procesamiento de datos. Personas de diferentes industrias comenzaron a comprender que sus ventajas dependerían de una forma u otra de la capacidad de almacenar y analizar información, así como de la velocidad de este análisis y el valor que se obtenga de él.

Con el advenimiento de la era de Internet, la transición a repositorios centrales de datos y el crecimiento exponencial de la cantidad de contenido web (a modo de comparación: en 1995 había 23.500 sitios web en el mundo, y un año después, más de 250.000), la pregunta Surgió la búsqueda entre la diversidad de contenidos existentes. A pesar de la existencia de varios motores de búsqueda ya creados en ese momento (por cierto, Yahoo no tuvo el suyo hasta 2002, pero utilizó desarrollos de terceros), el primero verdaderamente cercano a los modernos fue el sistema AltaVista. Lo que era único era que utilizaba un algoritmo lingüístico, dividiendo la frase de búsqueda en palabras y buscando en los índices existentes para clasificar el resultado. En dos años, el número de solicitudes por día pasó de 300.000 a 80 millones.

Todo lo que hablamos anteriormente son ejemplos de cuestiones relacionadas con el almacenamiento y procesamiento de información. Esta cadena puede continuar indefinidamente, pero el término Big Data en sí nos llegó solo con el cambio de milenio y, además de los enfoques que lo sustentaban, reveló al mundo toda la gama de problemas que enfrentaban las personas. desde el inicio de su historia de trabajo con la información.

La magia de la letra V

Antes de abordar el tema del Big Data, tecnologías y áreas de aplicación, es necesario hacer una observación y preparar el terreno para discutir el tema en sí.

El 6 de febrero de 2001, Doug Laney, de Meta Group (parte de Gartner), publicó un documento que describe las principales áreas problemáticas asociadas con los mayores requisitos de almacenes centrales de datos en medio del rápido crecimiento del comercio electrónico, así como la previsión de cambios en la estrategia. empresas sobre enfoques para construir la arquitectura de soluciones relacionadas con el almacenamiento y procesamiento de información.

Se han identificado tres áreas críticas en las que se debe centrar la atención para abordar los problemas de gestión de datos: volumen , velocidad y variedad . Estos conceptos luego se convirtieron en la base de un modelo descriptivo de Big Data llamado 3V (VVV).

Hay que tener en cuenta que estos aspectos se discutieron sin hacer referencia al concepto de Big Data, cuyo concepto comenzó a aplicarse un poco más tarde, pero estos parámetros, como ningún otro, describieron los principios básicos de lo que llamamos Big Data. .

Volumen

La importancia de adoptar el enfoque correcto para aumentar los volúmenes de datos es inherente al concepto mismo de Big Data. Pero, ¿cómo determinar este umbral que distingue el almacenamiento regular del Big Data? La respuesta es simple: en absoluto. Big Data no es una lista de valores estáticos, al alcanzar los cuales se determina la propiedad de la solución, sino un conjunto completo de métodos y tecnologías para obtener, almacenar y procesar información, independientemente de la presencia o ausencia de estructura en la misma.

Veamos este punto con el ejemplo de Facebook, ya que la industria de las redes sociales ya no se puede imaginar al margen del uso de tecnologías Big Data. Cada 60 segundos, se cargan más de 130.000 fotografías y se añaden o actualizan alrededor de 1.000.000 de entradas, sin olvidar la incorporación de nuevos usuarios a los dos mil millones existentes, así como la comunicación entre ellos y la incorporación de contenidos multimedia. ¿Gran cantidad de datos? Sin duda. Pero imaginemos que Facebook se limitara únicamente a recibir, almacenar y proporcionar esta información previa solicitud. Este enfoque no podría clasificarse como Big Data. Sería simplemente una enorme cantidad de datos.

La información en sí misma no es poder; de lo contrario, las personas más poderosas serían los bibliotecarios.

Una aclaración más importante. Cuando se opera con tales volúmenes de información, es muy importante estar preparado para un rápido escalamiento horizontal de todo el sistema agregado debido al crecimiento potencial de los datos entrantes.

Sigamos entendiendo este problema aún más profundamente y pasemos al siguiente parámetro.

Velocidad

Velocidad de procesamiento. En el contexto de un aumento constante de datos, es necesario poder procesarlos a la velocidad requerida por los objetivos del proyecto en cuyo contexto se discute este parámetro. Imaginemos que todas las minas de nuestra vasta patria están equipadas con cientos de sensores. Analizan miles de parámetros del ecosistema de una mina en particular, que luego se envían a un hub, que transmite todo el flujo al centro de datos central, donde se procesa y analiza la información recibida.

Estos datos son variados e incluyen, entre otros, niveles de sustancias nocivas, lecturas sísmicas y otra información que puede indicar la probabilidad de un colapso, fuga de gas u otras consecuencias catastróficas posibles en una mina en particular. Ahora imagine que los datos recibidos, por una razón u otra, se procesaron en 2 horas en lugar de, digamos, 10 minutos y el resultado del procesamiento fue información sobre un alto riesgo de colapso que ocurrió durante el análisis de esta información y, por lo tanto, se tomaron medidas preventivas. no fueron tomadas.

El ejemplo , quizás inverosímil, pero refleja bien la esencia de la velocidad, de la que a menudo depende otro parámetro que IDC agregó a esta cadena de tres V : el valor, o el valor de la información. En nuestro ejemplo, este valor era igual a cero, ya que perdió su relevancia antes de poder ser utilizado durante el período V de validez de esta información, que indica su vida útil. En otro contexto, el parámetro V alor debe considerarse como el valor de los datos, es decir, si nos ayudó a obtener datos listos para el análisis después del procesamiento o si fue inútil para nosotros.

Podemos llegar a la conclusión de que la velocidad del procesamiento de datos, al igual que el almacenamiento, debería aumentarse fácilmente si fuera necesario, lo que también se incluye en algunas tecnologías Big Data que permiten procesar la información de forma descentralizada. Esto hace posible escalar las soluciones de manera más flexible.

Así que aprendimos otra área donde el uso de Big Data está más que justificado: es IOT, o Internet de las cosas, que desde hace mucho tiempo ha pasado de la esfera doméstica de los hogares inteligentes a algo más.

Variedad

Todos los ejemplos de trabajo con información de nuestra introducción histórica se redujeron a trabajar con datos estructurados de una forma u otra. Pero, ¿qué hacer si la información llega de forma no estructurada y no se puede clasificar en secciones? Ya en 1998, el banco de inversión Merrill Lynch afirmó que hasta el 90% de toda la información potencialmente útil no está estructurada.

Digamos que decides analizar el sistema de correo electrónico de tu empresa (con el consentimiento de tus empleados, por supuesto). Los datos que se pueden llamar estructurados son el nombre del remitente, el destinatario, la fecha de envío, la recepción y otra información que se puede definir explícitamente en una celda de la base de datos previamente acordada. No hay problemas en esta etapa y si decide recopilar información sobre el número de cartas, la frecuencia de envío o, digamos, el tamaño promedio de una carta, puede hacerlo fácilmente. Pero, ¿qué hacer con los archivos adjuntos o el texto del correo electrónico? ¿Qué información puede obtener simplemente distribuyéndolos en campos de texto o adjuntos si, por ejemplo, desea saber si sus empleados escriben poesía en correspondencia o utilizan el correo corporativo para fines personales? Sin minería de datos, es imposible entender este tema.

Aparte del ejemplo anterior, cualquier dato que no pueda asociarse con un modelo existente puede considerarse no estructurado. Por tanto, una de las tareas que se plantea antes de utilizar Big Data (en mayor medida que almacenar información) es recibir como entrada una gran variedad de datos de diferentes tipos, construir rápidamente conexiones entre ellos y, en la salida, proporcionar los datos disponibles. para análisis estructurados o semiestructurados.

Resumamos todo lo que hablamos hoy e intentemos formular en pocas palabras lo que sabemos sobre Big Data.

En primer lugar, una gran cantidad de datos no siempre indica que un sistema resuelva los problemas de Big Data.

En segundo lugar, es importante mantener la velocidad requerida en el procesamiento de los datos entrantes; de lo contrario, puede perder su valor y transferir datos no válidos para su posterior análisis o, como resultado, proporcionar información irrelevante.

En tercer lugar, es importante poder encontrar conexiones entre cualquier dato, independientemente de su nivel de estructura, y poder obtener un resultado que pueda analizarse sin ambigüedades para resolver un problema particular.

En cuarto lugar, el sistema debe ser bien escalable a nivel lógico; de lo contrario, corremos el riesgo de recibir datos poco fiables debido a la pérdida de una de las V mágicas , cuya pérdida es inevitable en presencia de un flujo de información mayor del que podemos procesar.

Resulta que Big Data es un sistema escalable horizontalmente que utiliza un conjunto de técnicas y tecnologías que permiten procesar información estructurada y no estructurada y construir las conexiones necesarias para obtener datos que sean interpretables de forma única por una persona, no ha perdido su relevancia. y lleva el valor de los objetivos que persigue.

Muchos pueden añadir algo, porque quizá haya tantas definiciones de Big Data como empresas que lo utilizan. Pero esta definición nos bastará para pasar a la segunda parte del artículo, donde veremos ejemplos y áreas de aplicación, y también hablaremos de las tecnologías que se utilizan en Big Data.

Manuel García

Experto del mundo digital con experiencia en SEO y redacción web. Con una sólida formación en comunicación y tecnología, he dedicado los últimos años a perfeccionar mis habilidades en la creación de contenido web de calidad.